比Gemini还狠?MiniMax-M1上线,支持100万输入+8万输出

发布时间:2025-06-18 点击率:1747

中国AI公司 MiniMax 正式宣布开源其新一代推理模型 MiniMax-M1 ,该模型以 4560亿参数规模、2.8亿激活参数 构建,原生支持 100万个token输入和8万个token输出 ,是目前全球首个开放权重的大规模混合注意力推理模型。

这一重磅发布的背后,不仅标志着中国企业在大模型研发领域持续突破边界,更意味着长上下文处理能力正式迈入“百万级”时代。

MiniMax-M1 是基于此前发布的 MiniMax-Text-01 模型进一步优化而来,采用了以下核心技术:

- MoE(混合专家)架构 :提升模型扩展性和效率。

- 闪电注意力机制 :实现高效计算扩展,尤其适用于长文本生成。

- 强化学习训练 :涵盖数学推理、沙盒环境编程、工具调用等复杂任务。

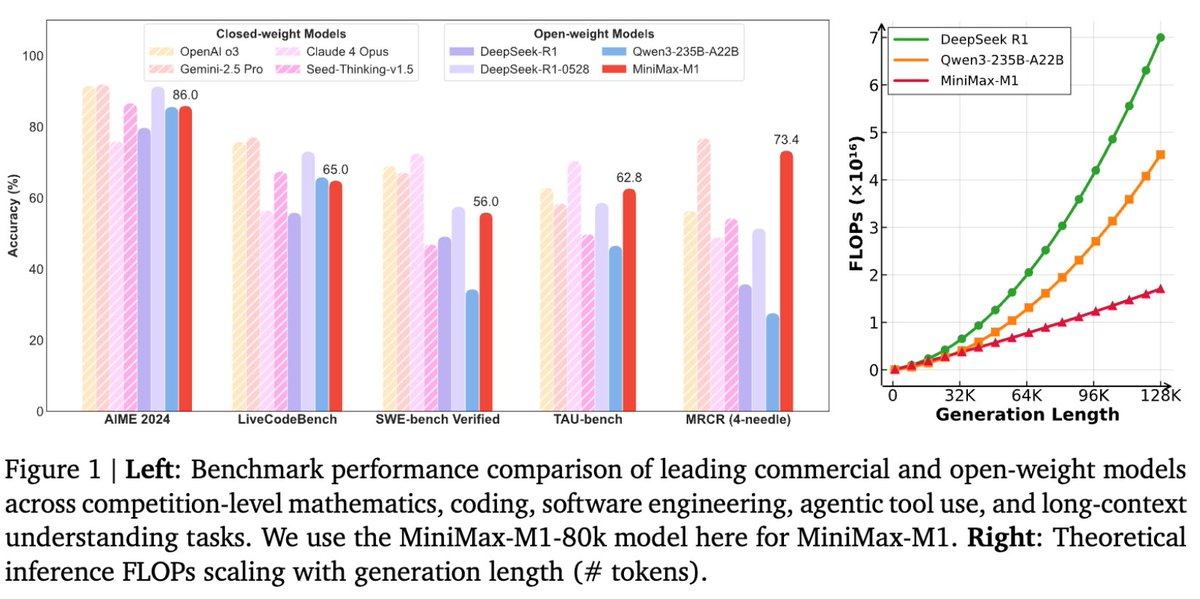

凭借这些创新设计,MiniMax-M1 在多个关键指标上超越当前主流开源模型,甚至接近国际领先水平。

核心功能亮点

支持百万级上下文长度

MiniMax-M1 原生支持高达 100万token的输入长度 ,是 DeepSeek R1 的 8倍 ,与 Google Gemini 2.5 Pro 相当。同时支持 8万token输出长度 ,非常适合处理长文档、多轮对话、代码理解等需要深度上下文的任务。

高效推理与成本优化

为适应不同场景,MiniMax-M1 提供两种推理预算版本:

- 40K token 版本

- 80K token 版本

通过闪电注意力机制优化计算资源使用,在生成 100K token 时,FLOPs 仅为 DeepSeek R1 的 25% ,显著降低推理成本。

多领域任务优化

MiniMax-M1 经过大规模强化学习训练,擅长处理多种高难度任务,包括:

- 数学推理

- 软件工程与编程任务

- 长上下文理解

- 工具调用与结构化输出

它能够识别并输出外部函数调用参数,便于与各类工具系统集成,具备极强的可操作性。

性能表现亮眼,对标国际顶尖水平

根据官方测试结果,MiniMax-M1 在多项标准基准测试中展现出卓越性能:

MiniMax 官方表示,该模型在性价比方面达到行业领先水平,是当前最具实用价值的开源推理模型之一。

开放共享,推动AI普惠发展

MiniMax-M1 的开源发布,无疑将进一步推动长上下文、高效推理、工具调用等方向的研究与应用落地。对于科研机构、开发者社区以及企业用户来说,这不仅是一个强大的基础模型,更是构建下一代 AI 代理、自动化系统和智能助手的理想选择。

项目官网:https://chat.minimaxi.com/

GitHub:https://github.com/MiniMax-AI/MiniMax-M1

上一篇: MNN TaoAvatar -...

下一篇: 没有了